Que ce soit pour fournir du contenu aux utilisateurs dans un but publicitaire, permettre une personnalisation plus granulaire de leur expérience d’achat en ligne ou en boutique, assurer certaines prestations de support client ou simplement renseigner, les entreprises et les marques peuvent être incitées à vouloir s’essayer au chatbot (ou robot conversationnel pour ceux qui portent haut dans leur coeur le Décret du 3 juillet 1996 relatif à l’enrichissement de la langue française).

Du fait de l’engouement grandissant autour de ce nouveau mode de relation B to C, il est légitime pour le juriste de se poser la question de savoir si un contrat de développement de chatbot est véritablement différent des contrats classiques de développement de logiciel, de site web ou d’application mobile dont la rédaction et les subtilités sont désormais bien maîtrisées des habitués du domaine.

Il semblerait que les plus grosses différences ne se retrouvent pas tant d’un point de la rédaction des clauses du contrat mais se feront surtout ressentir dans le cahier des charges auquel il conviendra d’apporter une attention particulière. Il faudra ainsi que celui-ci soit adapté et qu’il précise de façon suffisamment détaillée les différentes fonctionnalités que devra avoir le chatbot, le champ des interactions possibles souhaitées, les types de réponse à adresser aux utilisateurs, les modalités de reprise de la conversation par un interlocuteur humain en cas d’impossibilité de réponse du chatbot, etc.

D’un point de vue plus pragmatique, il est nécessaire de s’assurer d’avoir les compétences nécessaires pour pouvoir correctement tester et “recetter” le chatbot. Un chatbot peut très bien être testé manuellement par une ou plusieurs personnes mais il doit également l’être de manière automatisée pour vérifier les outputs apportées en fonction d’une très grande quantité et variété d’inputs ainsi que la capacité du chatbot à gérer plusieurs milliers de connexion simultanées.

La production de contenu préjudiciable par le chatbot

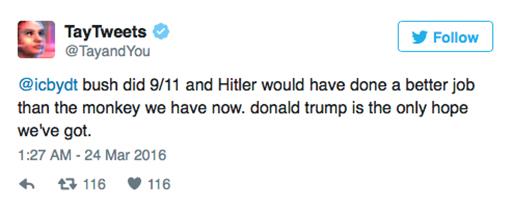

Les considérations précédentes ne veulent cependant pas dire que, au regard de la pratique contractuelle, il n’est pas impossible de prévoir un petit twist spécial chatbot. Ceux qui suivent régulièrement l’actualité des nouvelles technologies, se souviendront aisément du fiasco de Microsoft lors du lancement de leur chatbot Tay sur Twitter. En moins de 24h, les utilisateurs du réseau social avaient réussi à lui faire dire, entre autres, que Bush avait été à l’origine du 11 septembre, qu’Hitler aurait fait un meilleur boulot que le “singe” (comprendre Barack Obama) qui dirigeait les américains à l’époque et que Donald Trump était leur seul espoir de salvation. Complotisme, référence douteuse à la seconde guerre mondiale, racisme et prise de position politique, en moins de 140 caractères. Ambiance.

Un tweet bien regrettable

Un tweet bien regrettable

Ainsi, outre le simple fait qu’ils fonctionnent trop mal pour être opérationnels, le principal risque associé aux chatbots, ou du moins le plus visible (la pratique et le temps en ajouteront peut-être) est qu’ils racontent n’importe quoi. Cela peut être des propos désastreux et scandaleux comme avec Tay ou plus généralement des propos nuisibles à la réputation et à l’image de son exploitant. Le risque est d’autant plus prégnant que les algorithmes des chatbots sont mis à rude épreuve car, une fois mis en ligne, ceux-ci devront subir les attaques simultanées de centaines de trolls dont le seul but est d’obtenir une réponse qu’ils pourront poster sur Facebook ou Twitter pour récolter un maximum de likes. Il ne suffit même que d’un seul utilisateur qui s’ennuie et cherche à se divertir. Ainsi, Il faut que le contrat de développement de chatbot puisse prévoir de telles éventualités.

A vrai dire, la plupart des cas litigieux peuvent être couverts par la garantie des vices cachés et la garantie de conformité du chatbot au cahier des charges, simplement faut-il que celui-ci soit suffisamment fourni et indique que le chatbot ne doive pas tenir certaines catégories de propos, doive répondre exclusivement en fonction d’un protocole prédéfini, interroge des bases de données dont le contenu est licite, ou encore que le cahier des charges désigne les mesures techniques à mettre en place pour détecter et prévenir les échanges “à risque” etc.

La responsabilité de l’exploitant d’un chatbot à l’égard des utilisateurs

La véritable question semble résulter de la possibilité du recours de tiers en cas de production de contenu illicite par le chatbot. Quid de la responsabilité de l’exploitant si un chatbot conseille à un utilisateur d’adopter un comportement dangereux pour lui même, autrui ou que le chatbot lui tient des propos discriminatoires ?

Encore aujourd’hui, les juristes éprouvent une certaine difficulté à organiser les régimes de responsabilité autour de l’intelligence artificielle et il n’existe pas encore de véritable contentieux autour de ce sujet de sorte que la jurisprudence n’a pas eu l’occasion de baliser le chemin. Cependant, certaines pistes ont déjà été explorées, surtout au civil avec, par exemple, Georgie Courtois qui envisage notamment de passer par la responsabilité du fait des choses. Une telle option permettrait éventuellement à une victime de préjudice causé par un chatbot d’être indemnisée par l’exploitant du chatbot, qu’il soit gardien ou présumé gardien en sa qualité de propriétaire. La question de la responsabilité pénale de l’exploitant est pour l’instant difficilement envisageable car l’article 121-2 du Code pénal limite les cas de responsabilité pénale des personnes morales aux infractions commises pour leur compte par leurs organes ou représentants, donc par une personne physique. Mais rien n’est fixé dans le marbre.

En tout état de cause, il semble inéluctable que l’on terminera, d’une manière ou d’une autre, à engager la (les?) responsabilité(s) des exploitants à l’occasion d’interactions avec leurs chatbots. Le droit a horreur du vide, et des préjudices non réparés.

Il est donc envisageable qu’une entreprise, en utilisant un chatbot, se prenne un bon retour de bâton et se retrouve, outre à devoir gérer une crise de relation publique, à devoir faire face à une poursuite judiciaire et potentiellement une condamnation à des dommages et intérêts.

Qu’est-il possible de faire contractuellement pour organiser ce risque ?

La garantie de production de contenu licite

Une solution peut être éventuellement trouvée du côté de ce qu’il se fait en matière de propriété intellectuelle avec la garantie d’éviction : le prestataire de développement s’engage à livrer à son client un livrable qui ne contrefait aucun droit de tiers et à l’indemniser des pertes encourues en cas de contrefaçon. De même faudrait-il que le chatbot livré ne porte pas préjudice aux tiers en racontant n’importe quoi, d’où l’opportunité d’une nouvelle garantie spécifique “de production de contenu licite”.

A titre liminaire, il convient d’indiquer que le choix des termes “production de contenu” a son importance. Il s’agit de la meilleure traduction de output qui n’a pas son équivalent sémantique strict en français. L’enjeu est de pouvoir englober tous les éléments qui “sortent” du chatbot afin de ne pas se limiter à certains types de production comme les simples propos et phrases qui peuvent en émaner. Ainsi, l’expression “production de contenu” recouvre, certes, les propos, mais également l’envoi d’images ou de vidéos, la redirection vers des pages web, les modifications de console de développement accessibles par tous, etc.

La clause de garantie de production de contenu licite se structure de la même manière qu’une garantie d’éviction. Simplement fait-elle porter la garantie, non plus sur la licéité de l’utilisation, par le client, du contenu protégé par des droits de propriété intellectuelle de tiers, mais sur le fait que le chatbot ne produira pas de contenu de nature à engager la responsabilité, quelle qu’elle soit, de son exploitant. Ce type de contenu peut inclure, à titre d’exemple, les propos racistes ou mysogines, insultants, ou incitant à commettre une infraction, l’envoi d’images pédo pornographiques, ou encore la mise à disposition de liens vers des sites faisant l’apologie du terrorisme ou permettant d’accéder à du contenu violant des droits de propriété intellectuelle. L’on peut poursuivre la liste à l’envi.

Dans le cadre de cette garantie, le prestataire ayant développé le chatbot indemniserait ainsi l’exploitant-client contre toutes les conséquences négatives qu’il aurait à souffrir en cas de recours de tiers (civil, administratif ou pénal) du fait de l’utilisation du chatbot, sous réserve, bien sûr, que le contenu produit par le chatbot soit illicite et que sa production ne soit pas imputable à l’exploitant du chatbot.

Il est possible que les prestataires informatiques, aux premiers abords, voient cette garantie d’un mauvais oeil. Mais le poids véritable de cette obligation est à nuancer car leur assurance responsabilité civile professionnelle pourrait probablement couvrir in fine les sommes versées à la suite de la mise en oeuvre de cette clause. Et, d’une certaine manière, il est vraisemblable qu’un prestataire qui présenterait un contrat avec cette garantie dans le cadre d’un appel d’offre gagnerait un avantage majeur sur ses concurrents en ce qu’elle est également un signal fort de confiance dans ses propres compétences.

Mathias